Moltbot isimli açık kaynaklı yapay zeka casusu, GitHub tarihinin en süratli büyüyen projelerinden biri haline geldi. Bu proje yalnızca birkaç hafta içinde 85.000 yıldız barajını aştı. Lakin bu büyük ilginin art planında önemli güvenlik kaygıları yatıyor. Güvenlik araştırmacıları, uygulamanın daima açık tasarımı ve sistem yöneticisi seviyesindeki erişim yetkisinin tehlikeli olduğuna dikkat çekiyor. Hatta bu açıkların kimi atak denemelerinde kullanıldığı belirtiliyor.

GitHub Rekorlarını Kıran Moltbot: Tanınan Ancak Tehlikeli

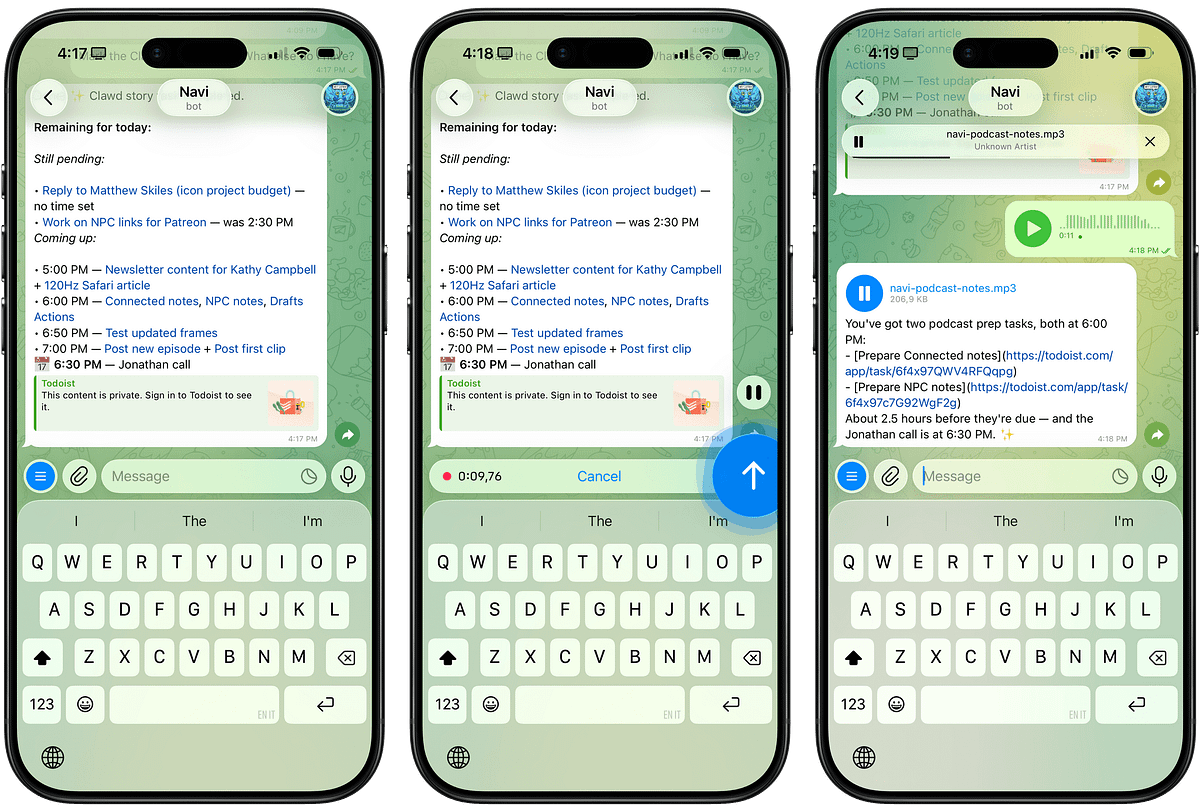

Avusturyalı geliştirici Peter Steinberger tarafından oluşturulan proje, daha evvel “Clawdbot” ismiyle biliniyordu. Lakin Anthropic şirketinin “Claude” ismine benzerlik nedeniyle marka tescili uyarısı yapması üzerine ismi 27 Ocak’ta değiştirildi. Kullanıcılar bu asistanı kendi aygıtlarında lokal olarak çalıştırabiliyor. Ayrıyeten WhatsApp, Telegram, Slack ve iMessage üzere uygulamalar üzerinden asistanla etkileşim kurulabiliyor.

Geleneksel yapay zeka asistanları komut beklerken, Moltbot art planda daima çalışan bir servis üzere davranıyor. Takvimlerden ve vazife yöneticilerinden sentezlenen sabah özetleri sunabiliyor. Kullanıcılar sisteme tam erişim izni verebiliyor. Bu sayede evrak okuyup yazma, komut evrakları çalıştırma ve tarayıcıları denetim etme üzere yeteneklere sahip oluyor. Bu özellikler, Iron Man sinemasındaki JARVIS ile karşılaştırılıyor. Aracın popülaritesi, altyapısında kullanılan teknoloji nedeniyle Cloudflare paylarını de hareketlendirdi.

Güvenlik firması Dvuln’un kurucusu Jamieson O’Reilly, aracın mimarisi hakkında önemli ihtarlarda bulundu. İnternet üzerinde kimlik doğrulaması olmayan yüzlerce Moltbot örneği tespit edildi. O’Reilly, platformun eklenti mağazası olan MoltHub üzerindeki bir güvenlik riskini de kanıtladı. Mağazaya zararsız bir eklenti yükleyip indirme sayısını yapay olarak şişirdi. Yedi farklı ülkeden on beş geliştirici bu eklentiyi kurdu. Şayet bu eklenti makus niyetli olsaydı, geliştiricilerin SSH anahtarları ve tüm kod tabanları çalınabilirdi.

Siber güvenlik platformu SOC Prime, problemlerin yanlış yapılandırılmış sunucu ayarlarından kaynaklandığını bildirdi. Bu kusur, internet ilişkilerinin sağlam lokal temaslar üzere algılanmasına neden oluyor. Intruder şirketinden güvenlik mühendisi Benjamin Marr, temel sorunun mimari olduğunu vurguladı. Projenin, varsayılan güvenlik ayarları yerine heyetim kolaylığına öncelik verdiği belirtiliyor. Google’ın güvenlik takımından Heather Adkins ise çok net bir ikazda bulunarak “Bu aracı çalıştırmayın” sözünü kullandı.

Tüm bu ihtarlara karşın projenin Discord topluluğu 8.900 üyeyi geçti. Kullanıcılar burada iş akışlarını paylaşmaya devam ediyor. Projenin kendi dokümantasyonunda ise bu durum kabul ediliyor. Bilgisayarınızda kabuk erişimine sahip bir yapay zeka casusu çalıştırmanın riskli olduğu ve “mükemmel güvenlikli” bir heyetimin mümkün olmadığı açıkça belirtiliyor.

Siz bilgisayarınızın tam denetimini, hayatı kolaylaştırsa bile bu türlü bir yapay zeka asistanına verir miydiniz? Yorumlarınızı bekliyoruz.